Qlik Replicate

Datenreplikation unabhängig vom Ort mit Qlik Replicate™

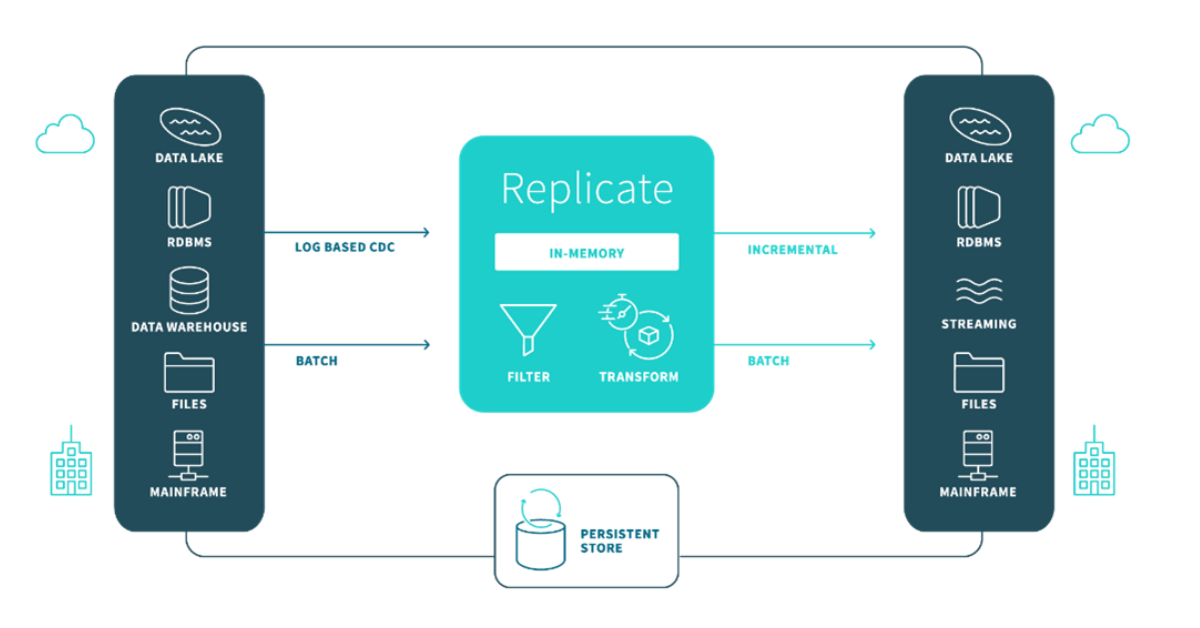

In den heutigen Unternehmen gibt es viele Quell- und Zielsysteme. Daten müssen repliziert werden, damit aussagekräftige Ergebnisse zustande kommen. Mit Qlik Replicate (ehemals Attunity Replicate) können Daten systemübergreifend erfasst, repliziert und gestreamt werden. Dabei arbeitet die Lösung mit geringster Belastung für das Quellsystem. Es ist egal wo die Daten liegen, On-Premise oder in der Cloud, Qlik Replicate synchronisiert die Systeme und die Daten werden einfach, sicher und effizient bewegt, ohne das operative Geschäft zu beeinträchtigen. Qlik Replicate bietet die Möglichkeit Daten in die Cloud migrieren, Aktualisierungen für einen Stream bereitstellen oder einen Data Lake kontinuierlich mit Daten versorgen. Mit Qlik Replicate stellen Sie eine universelle Datenverfügbarkeit her.

Daten aus allen wichtigen Datenbanken, Data Warehouses und Hadoop lassen sich mit Qlik Replicate systemübergreifend replizieren, synchronisieren, verteilen, konsolidieren und erfassen – On Premises und in der Cloud.

Qlik Replicate reduziert die Dauer des nächtlichen Batch-Ladevorgangs deutlich verkürzen,

Ein Kreditservice-Anbieter konnte 14 Millionen Änderungen aus der Quelle innerhalb von 30 Sekunden in das Ziel übertragen.

Ressourcenschonend durch Change Data Capture (CDC) Technologie

Beschleunigung von Migrations- und Analytics-Projekten

Wann sollten Sie sich für Qlik Replicate™ entscheiden?

Wenn Sie Daten in die Cloud migrieren, Aktualisierungen für einen Stream bereitstellen oder einen Data Lake kontinuierlich mit Daten versorgen wollen, verwenden Sie Qlik Replicate mit seiner intuitiven grafischen Benutzeroberfläche, der automatischen Datenerfassung und -replikation sowie den leistungsfähigen Echtzeit-Updates durch Change Data Capture (CDC). Wenn Sie die Zeit, Kosten und Risiken von Data-Warehouse-Projekten spürbar verringern möchten.

Qlik Replicate |

Qlik Compose |

Qlik Catalog |

|

Im Überblick

Integrationsaufgaben / Anwendungsfälle:

|

Im Überblick

IT-Teams aufgepasst

|

Im Überblick

|

Werden Sie Teil von Qlik Data Integration

Warum automatisierte-Data Warehouse-Lösungen agiler, kostengünstiger und flexibler sind als herkömmliche Lösungen.

Wie trotz der hohen verfügbaren Datenmengen in Zukunft weit mehr Analysemöglichkeiten und Analyseinitiativen bereitstehen, die Unternehmen wirklich voranbringen.

- Daten-Drehscheibe zur Datenhaltung an einem zentralen Ort.

- Neue DWH-Datenbanken in der Cloud

- DWH-Modellierung sowie automatische Tabellen- und ETL-Generierung.

- Real-Time-Daten-Streaming großer unstrukturierter Datenmengen. (CDC)

Qlik Replicate Look & Feel

Möchten Sie Qlik Replicate live erleben, dann sprechen Sie uns gezielt auf ein individuelles Webinar an: