Qlik Compose

Qlik Compose™ beschleunigt Projekte zu Data Warehouse und Data Lake

Die Data Integration Platform von Qlik unterstützt bei der Umsetzung einer unternehmensweiten Datenstrategie und beinhaltet Komponenten für die Datenhaltung und Datenflüsse im gesamten Unternehmen. Dabei spielt es keine Rolle, ob ein Data Warehouse, eine Clouddatenbank oder ein Datalake aufgebaut werden. Sicher ist, in jedem der Projekte ändern sich die Anforderungen schnell.

Traditionell werden die Anforderungen mithilfe von Programmierung umgesetzt. Qlik Compose (ehemals Attunity Compose) bietet eine effizientere Lösung, um Prozesse zu automatisieren und zu beschleunigen. Die Anforderungen werden dabei direkt in einer grafischen Oberfläche umgesetzt und führen so zu geringerem Zeit-, Kosten- und Entwicklungsaufwand.

Flexible Automatisierung von Data Warehouse

Qlik Compose for Data Warehouses (ehemals Attunity Compose) bietet ein modernes Konzept zur Automatisierung und Optimierung der Data Warehouse-Erstellung, –Bewirtschaftung und der -Administration.

Mit Qlik Compose entfällt die zeitaufwändige und fehleranfällige Entwicklung des ETL-Codes zur Einrichtung eines Data Warehouse.

Die Lösung automatisiert das Warehouse-Design, das Erzeugen des ETL-Codes und das Durchführen von Aktualisierungen. Dabei kommen Best Practices und bewährte Entwurfsmuster zum Einsatz. Ob On-Premise oder in der Cloud, Qlik Compose for Data Warehouses reduziert die Risiken, Zeit und Kosten für BI-Projekte erheblich.

Nutzen Sie die Vorteile durch die automatische ETL-Generierung: Qlik Compose ist bei der Bewirtschaftung eine große Entlastung.

Agile Data Warehouse-Automatisierung

Qlik Compose for Data Lakes

Qlik Compose für Data Lakes automatisiert Datenpipelines und sorgt für analysebereite Datensets.

Qlik standardisiert und kombiniert mehrere Änderungsströme zu einem verarbeitungsbereiten Datenspeicher im Data Lake. Daten aus mehreren Tabellen und/oder Quellen werden automatisch in ein flexibles Format und eine ebensolche Struktur überführt. Dabei bleibt die Änderungshistorie erhalten und wird sicher abgelegt.

So können Datennutzer:innen blitzschnell auf ihre zuverlässigen Daten zugreifen, inklusive der vollständigen Angaben zu deren Herkunft, ohne die vorausgehende automatische Strukturierung verstehen zu müssen:

- Pipeline-Automatisierung und -Orchestrierung

- Resilienz und automatische Reparaturfunktionen

- Problemlose Aufbereitung und Bereitstellung in jedem Maßstab

Der schnellste Weg zu analysebereiten Data Lake

Qlik Compose |

Qlik Replicate |

Qlik Catalog |

|

Im Überblick

IT-Teams aufgepasst

|

Im Überblick

Integrationsaufgaben / Anwendungsfälle:

|

Im Überblick

|

Werden Sie Teil von Qlik Data Integration

Nutzen und Orientierung für beide Wege

Was macht welche Lösung?

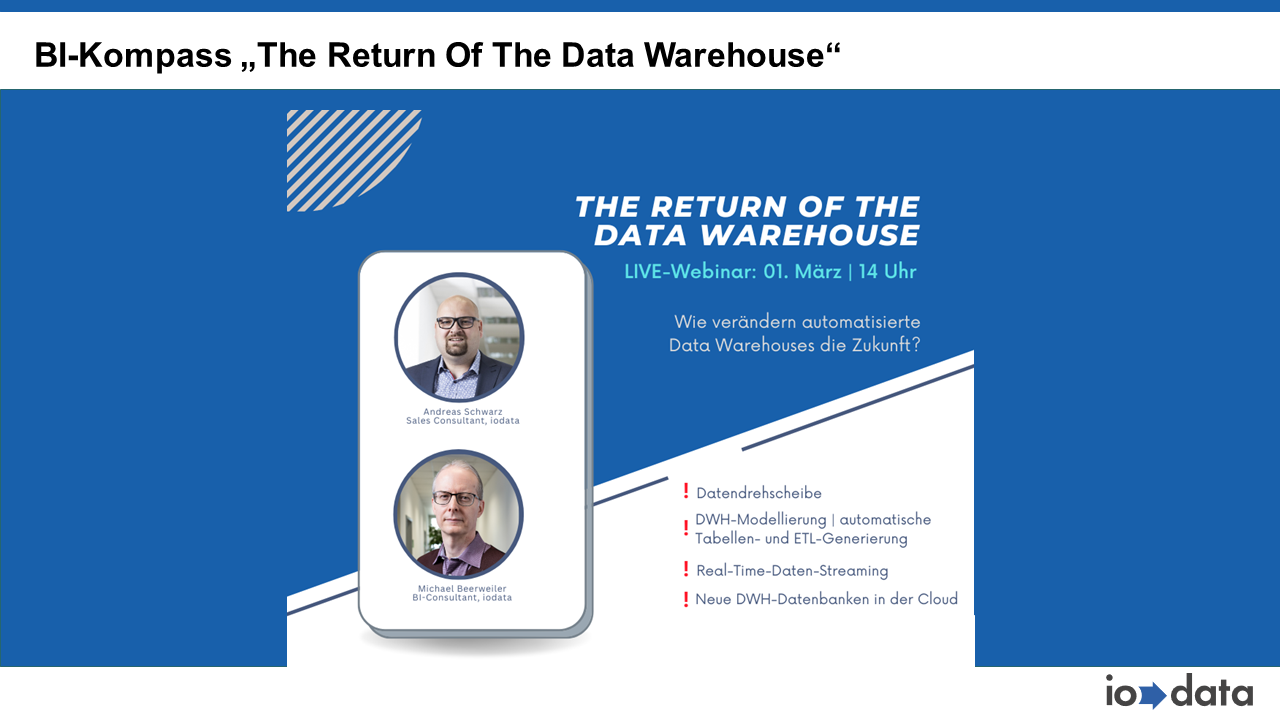

Wir streifen die aktuellen Themen, wie …

„Datenstrategie aus einer Hand“ mit Qlik.

Datenrückverfolgung durch „Data Lineage“.

Diskussion Qlik Sense? Data Warehouse?

Data Lake? oder Data Lakehouse?

60 Minuten „Wer braucht Was“? Qlik Sense oder Qlik Data Integration? Die integrierten Top-Features von Qlik data Intregration und Data Analytics. im Vergleich.

Qlik Compose Look & Feel

Möchten Sie Qlik Replicate live erleben, dann sprechen Sie uns gezielt auf ein individuelles Webinar an: